Quando si parla di smart TV o in generale di televisori moderni, il termine HDR è praticamente sempre presente. La prossima TV che comprerai sarà con ogni probabilità una TV 4K HDR, o in alcuni casi una TV 8K HDR. Al di là della risoluzione, il supporto HDR è diventato negli anni uno dei fattori più importanti nella qualità percepita, perché incide su contrasto, luminanza e resa delle luci. I produttori continuano a spingere nuove tecnologie e nuove sigle, ma non tutte sono equivalenti e, soprattutto, non tutte garantiscono lo stesso risultato sullo schermo.

4K HDR – Tutti i principali standard

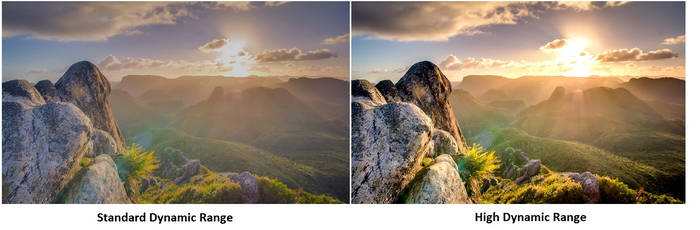

HDR sta per High Dynamic Range ed è una tecnologia ormai ben conosciuta anche dai videogiocatori. È arrivata nei salotti grazie alle TV 4K HDR e ai contenuti compatibili. In termini pratici, l’HDR può migliorare in modo sensibile la percezione dell’immagine: più dettaglio nelle zone luminose e in quelle scure, una maggiore profondità del contrasto e transizioni più graduali nelle sfumature. Perché l’HDR funzioni davvero, però, servono due condizioni: che il contenuto lo supporti (film, serie o videogioco) e che il televisore/monitor abbia caratteristiche tecniche adeguate per riprodurlo in modo credibile.

Il principio è simile a quello che alcuni conoscono dalla fotografia: si registrano e si gestiscono più informazioni sull’illuminazione di una scena, in modo da preservare dettagli che in SDR andrebbero persi nelle luci o nelle ombre. Più informazioni significa anche più gradazioni e più sfumature cromatiche, con conseguenze visibili soprattutto in scene complesse (cieli, controluce, riflessi, fuoco, neon). Concettualmente è un po’ come passare da un set di colori limitato a uno molto più ricco: non cambia solo “quanto è acceso” un colore, ma quante transizioni e mezze tinte riesci a vedere.

Attenzione però: HDR non significa automaticamente immagine migliore. Un HDR eccessivamente spinto può risultare fastidioso in alcune scene, e parte della resa dipende anche dalle scelte artistiche di color grading e master. Gli standard più comuni oggi sono HDR10, HDR10+, HLG e Dolby Vision. In mezzo c’è anche il tema più sottovalutato ma decisivo: come la TV/monitor fa il tone mapping, cioè come traduce il master HDR sul pannello reale.

Tone Mapping

Il tone mapping è il pezzo che spiega perché due TV HDR possono dare risultati completamente diversi anche guardando lo stesso film o lo stesso gioco. Un contenuto HDR viene masterizzato su monitor professionali con specifiche ben superiori a molti display domestici, e comunque con un target preciso (luminosità di picco, curva di trasferimento, gestione delle luci). Il problema è che ogni TV e ogni monitor consumer ha limiti reali: un certo picco di luminanza, un certo contrasto, un comportamento specifico nelle fonti di luce (ABL su OLED, zone di local dimming su LCD), e una gestione diversa delle scene molto luminose o molto scure. Il tone mapping è il processo con cui il display adatta quel master HDR alla propria capacità.

In pratica, quando una scena ha riflessi, sole, fuoco, neon o luci molto intense, la TV deve decidere: preservo dettaglio nelle luci e sacrifico un po’ di luminosità percepita, oppure spingo la luminosità e rischio di bruciare dettagli (clipping)? E nelle scene scure: alzo le ombre per far vedere tutto o mantengo un look più contrastato rischiando di perdere dettagli (black crush)? Queste scelte possono essere fatte in modo statico o dinamico, e qui nascono differenze enormi tra modelli e tra modalità immagine.

Molte TV moderne usano tone mapping dinamico, che analizza la scena in tempo reale e modifica curva e luminanza per massimizzare l’impatto. A volte è utile, altre volte altera l’intenzione artistica e rende l’immagine incoerente tra una scena e l’altra (specialmente nei film). Nei giochi il discorso cambia: il tone mapping doppio (gioco + TV) può creare risultati sbagliati, con immagini troppo scure o picchi di luminosità tagliati, e per questo esistono approcci come HGiG o modalità gaming che riducono l’intervento della TV e lasciano più controllo alla calibrazione del gioco.

Il punto pratico è questo: se un televisore dichiara HDR, non basta sapere che supporta HDR10 o Dolby Vision. Conta quanto bene gestisce il tone mapping nel mondo reale e quanto è coerente tra contenuti diversi. È anche il motivo per cui spesso conviene verificare recensioni tecniche o test indipendenti: due modelli con “HDR” sulla scatola possono comportarsi in modo opposto proprio per via del tone mapping.

Dolby Vision: lo standard migliore per TV 4K HDR

Dolby Vision è uno standard HDR avanzato, in genere considerato superiore a HDR10 perché può usare metadati dinamici, cioè informazioni che guidano la resa scena per scena (o frame per frame) in base al contenuto. In termini pratici, questo aiuta a ottenere un tone mapping più coerente: dettagli nelle luci più controllati, meno rischio di clipping e una resa più consistente tra scene diverse, soprattutto quando il master HDR supera le capacità reali del pannello.

Dal punto di vista teorico, Dolby Vision è nato per gestire contenuti con luminanza molto alta e profondità colore superiore rispetto al minimo comune denominatore. Nella realtà domestica, però, nessun televisore consumer riproduce per intero il potenziale massimo del mastering: quello che conta è come il dispositivo adatta il contenuto al suo picco reale, al suo contrasto e al suo comportamento nelle fonti di luce. Qui Dolby Vision spesso dà un vantaggio perché fornisce più informazioni al display per interpretare correttamente l’intenzione del master.

In generale, una TV che supporta Dolby Vision supporta anche HDR10, ma resta valido un punto: la qualità finale dipende comunque dalla catena completa (pannello, luminosità utile, contrasto, local dimming/OLED, algoritmi). Dolby Vision è un miglioramento che funziona bene quando il display è già buono.

HDR 10 e Ultra HD Premium: la base di partenza

HDR10 è lo standard HDR più diffuso e rappresenta la base di compatibilità per la maggior parte delle TV e dei contenuti. Usa metadati statici (quindi impostazioni generali per il film o l’episodio), ed è supportato praticamente ovunque. Spesso viene associato al termine Ultra HD Premium, ma è utile chiarire: Ultra HD Premium non è un formato HDR, ma un programma di certificazione con requisiti minimi su risoluzione, profondità colore, gamut e capacità HDR del display. Non tutte le TV HDR sono certificate Ultra HD Premium, anche se possono comunque offrire ottimi risultati.

In sintesi, i punti che contano davvero per capire HDR10/Ultra HD Premium sono: risoluzione 4K, profondità colore a 10 bit, copertura ampia dello spazio colore (DCI-P3) e capacità del display di offrire un contrasto credibile in HDR (con requisiti diversi per LCD e OLED). Il senso di questa certificazione era garantire che l’etichetta “HDR” non fosse solo marketing, anche se nel mercato reale esistono molte implementazioni diverse e non tutte vengono comunicate in modo chiaro.

Il concetto da tenere a mente è che HDR10 è il punto di partenza e assicura compatibilità, ma da solo non garantisce un HDR spettacolare: serve che il display abbia abbastanza controllo della luce (local dimming, mini-LED, o nero perfetto su OLED) e abbastanza luminanza utile per dare impatto alle fonti di luce senza schiacciare il resto dell’immagine.

HDR10+ come evoluzione dinamica

HDR10+ nasce come evoluzione di HDR10 con un obiettivo chiaro: introdurre metadati dinamici, cioè indicazioni che possono cambiare scena per scena su come gestire il tone mapping, senza rimanere fissi per l’intero contenuto. In questo senso si colloca concettualmente tra HDR10 (statico) e Dolby Vision (dinamico), con un approccio che mira a migliorare coerenza e preservazione dei dettagli nelle alte luci su display con capacità diverse.

In pratica, HDR10+ può aiutare quando il contenuto presenta forti variazioni di luminanza: scene molto buie alternate a scene abbaglianti, interni con finestre luminose, riflessi e luci puntiformi. Con metadati dinamici, il display riceve indicazioni più specifiche su come comprimere o preservare le fonti di luce e su come gestire il contrasto senza appiattire l’immagine. Il risultato potenziale è un HDR più controllato e meno soggetto a tagli netti nei dettagli, soprattutto su TV che non raggiungono i picchi del mastering.

La disponibilità di HDR10+ dipende dal supporto del produttore, dalla piattaforma e dai contenuti. Per chi compra una TV oggi, il punto pratico è che HDR10 resta la base di compatibilità, mentre HDR10+ e Dolby Vision sono dei plus legati a contenuti specifici e alla resa del tone mapping. Se si guarda molto streaming o si gioca in HDR, avere uno standard dinamico ben supportato può fare differenza, ma va sempre valutato insieme alla qualità reale del pannello e della gestione HDR.

HLG o Hybrid Log Gamma: da SDR a HDR

HLG (Hybrid Log Gamma) è uno standard pensato soprattutto per broadcast e compatibilità: può essere visto anche su TV SDR, pur offrendo vantaggi su TV HDR. Questo lo rende interessante per emittenti e contenuti live, perché non obbliga a distribuire due segnali separati. In genere HLG offre un miglioramento visivo rispetto a SDR, ma non ha la stessa finezza dei formati HDR con metadati dinamici nei contenuti cinematografici. Resta comunque uno standard diffuso e stabile, quindi ha senso che continui a essere supportato.

HDR su PC e console

Su PC e console l’HDR è più complesso che nei film per un motivo: non stai riproducendo un master fisso, ma un’immagine generata in tempo reale dal motore di gioco. Questo significa che la resa dipende da tre livelli: impostazioni del gioco, impostazioni del sistema (Windows/Linux/console) e impostazioni del display (modalità immagine, tone mapping, VRR e profili gaming). Se uno di questi livelli è fuori calibrazione, l’HDR può risultare peggiore dell’SDR: neri strani, immagine slavata, colori bizzarri o luci che sembrano bruciate.

Il primo punto pratico è la calibrazione. Su console esistono procedure guidate; su PC c’è la gestione HDR del sistema operativo e spesso strumenti dedicati. Se la calibrazione è troppo conservativa, l’HDR perde impatto; se è troppo aggressiva, le luci clipperanno e i dettagli nelle zone luminose spariranno. Il secondo punto è la modalità immagine: molte TV hanno profili “Gioco HDR” separati da “Cinema HDR”. Un profilo cinema può avere processamenti e ritardi che è meglio non avere in gaming, mentre un profilo gioco può limitare alcuni interventi per ridurre latenza e rendere la risposta più immediata.

Il terzo punto è l’interazione con il tone mapping. Nei giochi è comune che il motore faccia già una sua mappatura verso il target HDR; se la TV applica a sua volta un tone mapping dinamico aggressivo, i risultati diventano incoerenti. Per questo alcune modalità pensate per gaming mirano a rendere la risposta più prevedibile, lasciando al gioco (e alla calibrazione) la parte principale della resa HDR. In sostanza, su console e PC l’HDR funziona bene quando la catena è coerente: calibrazione corretta, modalità gioco appropriata e un display capace di gestire bene picchi e scene scure senza introdurre artefatti.

HGiG (gaming HDR su console e PC)

HGiG è un aspetto poco discusso fuori dalle community, ma in pratica è uno dei più importanti se si gioca in HDR su console o su PC collegato a una TV. Il problema è semplice: nei contenuti HDR il gioco produce una scala di luminanza e la TV deve decidere come tradurla sul pannello reale. Se sia il gioco sia la TV applicano un tone mapping aggressivo, il risultato può diventare incoerente: immagini troppo scure, highlight bruciati o colori meno leggibili, soprattutto nelle scene notturne o con effetti molto luminosi.

La filosofia HGiG serve a ridurre questo caos. In modalità HGiG la TV cerca di disattivare o limitare il tone mapping dinamico e lascia al gioco la responsabilità principale della mappatura HDR, a patto che l’utente abbia fatto correttamente la calibrazione HDR in console o nel gioco. In questo modo si ottiene un’immagine più prevedibile e spesso più fedele, con un miglior equilibrio tra dettagli nelle ombre e intensità delle luci. Non tutti i modelli implementano HGiG allo stesso modo e non sempre la dicitura è esplicita nei menu, ma quando presente è una funzione utile per chi gioca spesso in HDR e vuole risultati consistenti senza dover combattere con impostazioni diverse da titolo a titolo.

Potrebbero interessarti: